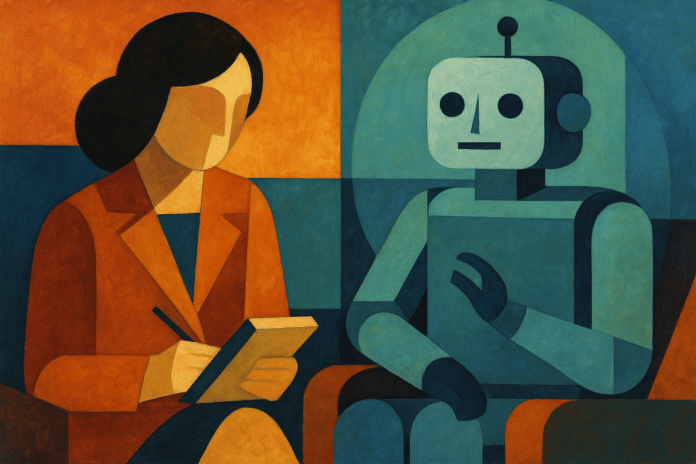

Non giudica, non interrompe, non sbuffa. È sempre disponibile, anche alle tre del mattino, quando l’ansia stringe più forte. Per molti adolescenti e giovani adulti, ChatGPT è diventato un confidente silenzioso: un “amico-psicologo” capace di restituire risposte immediate, ordinate, rassicuranti.

Secondo dati aggregati (Thunderbit, 2025), gli utenti attivi settimanali di ChatGPT hanno superato quota 400 milioni, con oltre un miliardo di interazioni al giorno. Dietro quella marea di conversazioni ci sono anche confessioni intime, richieste di aiuto, tentativi di lenire un disagio emotivo.

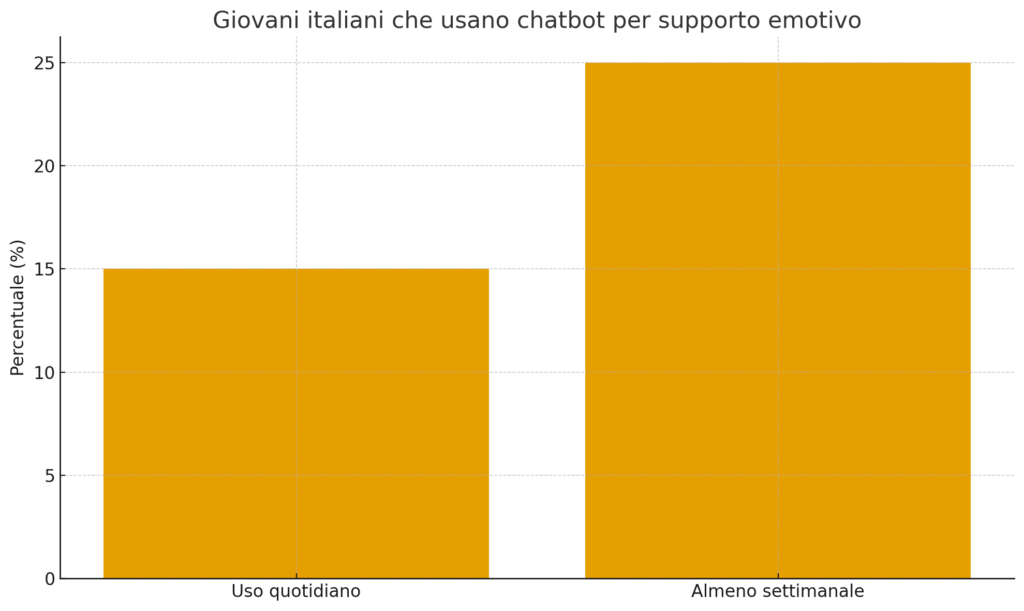

Un sondaggio condotto da Skuola.net e riportato dall’Istituto A. T. Beck mostra che il 15% dei giovani italiani usa quotidianamente chatbot per supporto psicologico e un ulteriore 25% almeno una volta a settimana. Numeri che raccontano un fenomeno culturale prima ancora che tecnologico.

Perché preferiamo un BOT a una persona?

Geopop ha provato a dare una risposta: con un algoritmo ci sentiamo al sicuro, protetti dall’anonimato, sottratti al rischio di giudizio. Non c’è imbarazzo, non c’è vergogna. In un’epoca in cui, come ricorda la sociologa Sherry Turkle, le relazioni si fanno sempre più mediate da uno schermo, la tentazione di affidarsi a una voce artificiale è forte.

Il paradosso è evidente: cerchiamo autenticità in una macchina programmata per restituire frasi plausibili, non sentimenti reali. “Empatia simulata”, la chiamano gli psicologi. Eppure funziona: almeno in superficie, allevia la solitudine.

Quando il chatbot diventa clinico

Se ChatGPT nasce come strumento generalista, esistono chatbot sviluppati con finalità terapeutiche. Il caso più noto è Woebot, che utilizza tecniche di terapia cognitivo-comportamentale.

Uno studio randomizzato pubblicato su JAMA Network ha coinvolto 184 neo-madri: dopo sei settimane, il gruppo che usava Woebot registrava una riduzione di oltre 5 punti nell’EPDS (scala di valutazione della depressione post-partum), contro appena 1 punto del gruppo di controllo. Il 70% mostrava un miglioramento clinicamente significativo.

Altri esempi includono Wysa e Fido, chatbot che hanno dimostrato in studi controllati un impatto positivo su ansia e depressione. Una meta-analisi su npj Digital Medicine (2023) conferma effetti moderatamente positivi dei conversational agents, pur con limiti metodologici e necessità di studi più solidi.

Le zone d’ombra

Gli esperti non hanno dubbi: nessun algoritmo può sostituire l’empatia umana. L’Istituto Beck avverte del rischio di consigli inadeguati, di isolamento rafforzato e di dipendenza emotiva da uno strumento che, per definizione, non sente né comprende.

Studi recenti hanno mostrato come i grandi modelli linguistici rispondano in modo incoerente e talvolta pericoloso a domande legate al suicidio o all’autolesionismo. In alcuni casi hanno fornito istruzioni dettagliate sui metodi: un campanello d’allarme che ha spinto Meta e OpenAI a introdurre sistemi di deviazione verso numeri di emergenza e risorse di supporto. Sono primi passi, ma ancora insufficienti.

Per chi chiedere aiuto

Se stai vivendo un momento di crisi o conosci qualcuno in difficoltà:

– Chiama il numero verde 1522 (violenza e stalking, attivo h24).

– Telefono Amico Italia: 02 2327 2327.

– In caso di emergenza grave, chiama subito il 118 o recati al pronto soccorso.

Non affidarti solo a strumenti digitali: la relazione umana resta fondamentale.

Una questione di cultura

Affidarsi a ChatGPT non è solo una scelta individuale: riflette una trasformazione collettiva. Anthony Giddens parlava di “fiducia astratta” nelle istituzioni moderne; oggi la estendiamo agli algoritmi. Byung-Chul Han descrive una società della stanchezza, in cui la solitudine diventa normalità. E Floridi ci avverte: viviamo immersi in un’infosfera dove la distinzione tra umano e artificiale diventa sempre più labile.

L’uso di ChatGPT come psicologo è il sintomo di una società che fatica a trovare spazi di ascolto reali e accessibili.

Scenari futuri

Gli esperti delineano alcuni percorsi possibili:

- Complementarietà: chatbot come strumenti di primo aiuto, integrati in percorsi clinici veri e propri.

- Regolamentazione: linee guida etiche per distinguere supporto informativo da terapia.

- Educazione digitale: insegnare a riconoscere i limiti dell’IA, soprattutto ai più giovani.

- Chatbot ibridi: modelli generalisti incapsulati in protocolli clinici con controlli umani e “uscite di sicurezza”.

La vera domanda

Non si tratta di chiedersi se ChatGPT potrà sostituire uno psicologo: la risposta è no. La questione è un’altra: quale ruolo vogliamo assegnare alla tecnologia nei momenti di fragilità?

Se l’algoritmo diventa un cuscinetto emotivo che prepara al contatto umano, può essere un alleato prezioso. Se invece diventa un surrogato che sostituisce relazioni autentiche, rischiamo di delegare la parte più fragile — e più umana — di noi stessi a una macchina.